Revista Electrónica Educare (Educare Electronic Journal) EISSN: 1409-4258 Vol. 25(3) SETIEMBRE-DICIEMBRE, 2021: 1-24

doi: https://doi.org/10.15359/ree.25-3.18

http://www.una.ac.cr/educare

educare@una.ac.cr

[Cierre de edición el 01 de Setiembre del 2021]

Diseño de un sistema de indicadores para la evaluación y selección de aplicaciones para personas con Trastorno del Espectro Autista

Design of an Indicator System for the Evaluation and Selection of Applications for People With Autistic Spectrum Disorder

Projeto de um sistema de indicadores para a avaliação e seleção de aplicações para pessoas com Transtorno do Espectro Autista

Carmen del Pilar Gallardo-Montes

Universidad de Granada

Facultad de Ciencias de la Educación

Departamento Didáctica y Organización Escolar

Granada, España

cgallardo@ugr.es

https://orcid.org/0000-0002-6510-2425

https://orcid.org/0000-0002-6510-2425

María Jesús Caurcel-Cara

Universidad de Granada

Facultad de Ciencias de la Educación

Departamento Didáctica y Organización Escolar

Granada, España

caurcel@ugr.es

https://orcid.org/0000-0002-2169-9100

https://orcid.org/0000-0002-2169-9100

Antonio Rodríguez-Fuentes

Universidad de Granada

Facultad de Ciencias de la Educación

Departamento Didáctica y Organización Escolar

Granada, España

arfuente@ugr.es

https://orcid.org/0000-0002-8036-9902

https://orcid.org/0000-0002-8036-9902

Recibido • Received • Recebido: 18 / 10 / 2019

Corregido • Revised • Revisado: 25 / 06 / 2021

Aceptado • Accepted • Aprovado: 12 / 08 / 2021

Resumen:

Objetivo: Las tecnologías de la información y la comunicación (TIC) aportan a las personas con trastorno del espectro autista (TEA) un abanico de posibilidades de desarrollo. A su vez, son numerosas las aplicaciones (apps) destinadas a personas menores con autismo, por lo que esta propuesta pretende ofrecer un listado de indicadores validados que analicen las fortalezas y debilidades de dichas apps. Metodología: El análisis exhaustivo de estudios previos ha permitido la creación de este instrumento, en relación con el diseño de la app, su contenido y sus aspectos pedagógicos. A través de un estudio instrumental de validez de contenido, se procedió a validar el sistema de indicadores (según su claridad, coherencia, relevancia y objetividad), para lo cual se aplicó el método del juicio experto. Resultados: Un total de 12 jueces han puntuado entre buenos y excelentes cada uno de los indicadores y subindicadores diseñados, con unos coeficientes de correlación intraclases excelsos, una concordancia inter-jueces W de Kendall significativa y fuerte, y unos niveles de consistencia interna elevados. Se constató que se trata de un instrumento válido y fiable. Discusión: Los resultados positivos derivados de la validación del instrumento han dado lugar a un sistema de indicadores compuesto por criterios deseables para una app destinada a personas con este trastorno. Especialistas en TEA y familiares van a contar con una herramienta intuitiva para la selección de apps adecuada a las necesidades del colectivo, que abarca distintos parámetros.

Palabras claves: Aplicación informática; educación especial; indicadores educativos; instrumento de medida; tecnología educacional; TIC; trastorno del espectro autista.

Abstract

Objective: Information and communication technologies (ICT) provide people with autism spectrum disorder (ASD) with a wide range of possibilities for development. At the same time, there are numerous applications (apps) aimed at children with autism; so, this proposal aims to offer a list of validated indicators that analyze the strengths and weaknesses of these apps. Methodology: The exhaustive analysis of previous studies has allowed the creation of this instrument in relation to the design of the app, its content, and its pedagogical aspects. According to its clarity, coherence, relevance, and objectivity, the system of indicators was validated through an instrumental study of content validity, applying the method of expert and judges’ judgment. Results: A total of 12 judges scored each of the designed indicators and sub-indicators as good to excellent, with excellent Intraclass Correlation coefficients, significant and strong Kendall’s W inter-judge agreement, and high levels of internal consistency. It was found to be a valid and reliable instrument. Discussion: The positive results derived from the validation of the instrument have resulted in a system of indicators composed of desirable criteria for an app for people with ASD. ASD specialists and family members will have an intuitive tool for the selection of apps adapted to the needs of this group, covering different parameters.

Keywords: Autism spectrum disorder; computer applications; educational indicators; educational technology; ICT; measuring instrument; special education.

Resumo

Objetivo: As Tecnologias de Informação e Comunicação (TIC) proporcionam às pessoas com Desordem do Espectro do Autismo (DEA) uma gama de possibilidades de desenvolvimento. Por sua vez, existem numerosas aplicações (apps) destinadas a crianças com autismo, pelo que esta proposta visa fornecer uma lista de indicadores validados que analisam os pontos fortes e fracos destas aplicações. Metodologia: A análise exaustiva de estudos anteriores permitiu a criação deste instrumento, em relação à concepção da aplicação, ao seu conteúdo e aos seus aspectos pedagógicos. Através de um estudo instrumental da validade do conteúdo, procedemos à validação do sistema de indicadores (de acordo com a sua clareza, coerência, relevância e objetividade), aplicando o método de julgamento de peritos e juízes. Resultados: Um total de 12 juízes pontuaram entre bom e excelente cada um dos indicadores e subindicadores concebidos, com excelentes coeficientes de correlação intraclasse, uma concordância significativa e forte entre juízes W de Kendall, e altos níveis de consistência interna. Foi considerado como um instrumento válido e fiável. Discussão: os resultados positivos derivados da validação do instrumento resultaram num sistema de indicadores composto de critérios desejáveis para uma aplicação a pessoas com esta desordem. Os especialistas em DEA e membros da família terão um instrumento intuitivo para a seleção de aplicações adaptadas às necessidades coletivas, abrangendo diferentes parâmetros.

Palavras-chave: Aplicação informáticas; educação especial; desordem do espectro autista; indicadores educacionais; instrumento de medição; tecnologia educacional; TIC.

Introducción

Resultan sorprendentes los avances desarrollados en el campo de la educación en consonancia con las tecnologías de información y la comunicación, situándonos en un momento en el que el acceso a diversidad de materiales educativos está a solo un click. El ámbito de la educación especial y, en concreto, el del trastorno del espectro autista (TEA), cuenta con profesionales que ofrecen plataformas de consulta y desarrollan materiales online para familias, especialistas en TEA y personas con este trastorno.

Las TIC constituyen una herramienta más manipulativa, auditiva y visual (González Cintado et al., 2016; Rodríguez Fuentes, 2017), adaptada a sus necesidades y que ofrece múltiples ventajas a la hora del trabajo con personas con TEA. Parsons et al. (2006) y Terrazas Acedo et al. (2016) coinciden en que ayudan al desarrollo y promoción de habilidades sociales. Pero no solo desarrollan aspectos vinculados al ámbito social y emocional, sino que aumentan la motivación hacia este tipo de tareas (Lozano Martínez et al., 2014). Guzmán et al. (2017) señalan que “el uso de tecnologías para mejorar y estimular, particularmente, la comunicación de los niños con TEA ha aumentado en los últimos tiempos de manera exponencial” (p. 248), y abre un mundo de posibilidades para poder desarrollar otras habilidades en déficits como la atención, anticipación, funciones ejecutivas, memoria de trabajo, secuencias de acciones, organización de eventos, etc.

En relación con el uso de aplicaciones móviles y sus beneficios para personas con TEA, Flores et al. (2012) demuestran que, a través de aplicaciones destinadas al aumento de la comunicación, se potencian los comportamientos vinculados a esta misma, motivando la intención comunicativa. Igualmente, Jiménez Lozano et al. (2017) obtienen resultados positivos empleando aplicaciones cuya finalidad era el uso de sistemas aumentativos de comunicación, fomentando la comunicación y promoviendo el desarrollo de la expresión. A su vez, en este estudio se reflejan experiencias (Bellini y Akullian, 2007; Cafiero, 2005; Mirenda, 2001; Mirenda et al., 2000) que ofrecían resultados beneficiosos, en de la idea de que el formato visual que ofrecen los dispositivos móviles estimula la socialización y comunicación de la niñez con TEA.

Las TIC, hoy, ya no resultan un recurso tan novedoso como años atrás, pero su uso continuado precisa de una revisión constante, para plantear adecuadamente qué es lo que se va a trabajar con ellas y qué se quiere conseguir. Así, como señalan Campos Jiménez et al. (2014), internet es una excelente herramienta a la hora de encontrar material educativo, pero si se realiza una búsqueda acerca del autismo se cuentan por cientos las webs y aplicaciones (apps) que presentan herramientas actualizadas para padres y profesionales. Ahora bien… ¿qué se ofrece a las personas con TEA? Al realizar esa búsqueda aparecen multitud de aplicaciones, muchas más que para otros colectivos como síndrome de Down o parálisis cerebral (Larco et al., 2015), sin poder distinguir, a priori, en qué se diferencian o cuáles son mejores. Las familias al ofrecer a las personas con TEA el dispositivo móvil suelen hacerlo confiando en que determinadas aplicaciones, al estar creadas especialmente para este colectivo, van a cumplir con el fin esperado, pero no siempre es así. Haciendo un barrido en Google Play Store, utilizando como palabra clave “autismo”, se encuentran alrededor de 230 aplicaciones -búsqueda realizada el 17/07/2018-, pero profundizando un poco más se observa que muchas de estas no tienen relación directa con el autismo. Dado el auge tanto en cantidad como en diversidad, asumida la funcionalidad del medio digital a través de aplicaciones, pero detectada la inespecificidad de gran número de ellas, se pretende establecer unos criterios que determinen por qué una es mejor que otra y cuál de ellas emplear para así facilitar su selección por parte de familiares y profesionales.

Son varios los estudios que han trabajado sobre este tema, con la finalidad de establecer parámetros de evaluación de aplicaciones o plataformas web. Belloch Ortí (2006) plantea una serie de criterios de calidad para evaluar aplicaciones multimedia, entre los que destacan los estéticos, pedagógicos y funcionales; indica, a su vez, aspectos económicos y técnicos. Asimismo, Araujo et al. (2007) proponen “criterios de evaluación … [de] aplicaciones multimedia en entornos de educación y formación a distancia” (p. 3), que plasman la necesidad de evaluarlas partiendo de tres análisis previos: descriptivo, atendiendo a aspectos técnicos, diseño, objetivos y contenidos; pedagógico, indagando las actividades, materiales o evaluación; y didáctico, desarrollando parámetros ligados a operaciones cognitivas, creatividad o motivación. Por su parte, Larco et al. (2015) evalúan aplicaciones educativas para público usuario con discapacidad intelectual, incluyendo algunas para personas con autismo, donde los elementos valorados se relacionan con la funcionalidad, estética, información ofrecida, calidad…

En el trabajo de García-Rodríguez y Gómez-Díaz (2015) se plantean una serie de indicadores con los que evaluar las aplicaciones destinadas a la lectura infantil, ya que como destacan en su trabajo, “la cantidad y variedad de aplicaciones es grande” (p. 2). A su vez, también afirman que, pese a la diversidad de estudios previos sobre aplicaciones, pocos son los que profundizan en evaluarlas. Las autoras ofrecen una plantilla que recoge aspectos fundamentales a evaluar respecto a las dimensiones forma y contenido.

Con esta investigación se pretende ofrecer un sistema de indicadores de calidad para evaluar aplicaciones para dispositivos móviles destinadas a público usuario con TEA. La idea principal es que familias y profesionales cuenten con una herramienta desarrollada en profundidad con la que determinar qué aplicaciones son las más adecuadas en función del área que quiera trabajarse: comunicación, emociones, gestión del tiempo, habilidades instrumentales básicas –desarrollo del lenguaje, matemáticas, aprendizaje de las letras…–, funciones ejecutivas –organización, memoria, atención…– y ocio.

Metodología para evaluar las aplicaciones para personas con TEA

Los aspectos que se evalúan se encuentran en consonancia con criterios deseables para una aplicación destinada a este colectivo, por lo que los indicadores, y sus consecuentes explicaciones, son rigurosos y analizados desde un punto de vista psicopedagógico. La utilización de un sistema de indicadores es un recurso útil para evaluar de manera tangible productos o servicios ofrecidos. El desarrollo de los indicadores que se presentan ha sido elaborado partiendo de los trabajos previos de Araujo et al. (2007), Belloch Ortí (2006) y García-Rodríguez y Gómez-Díaz (2015).

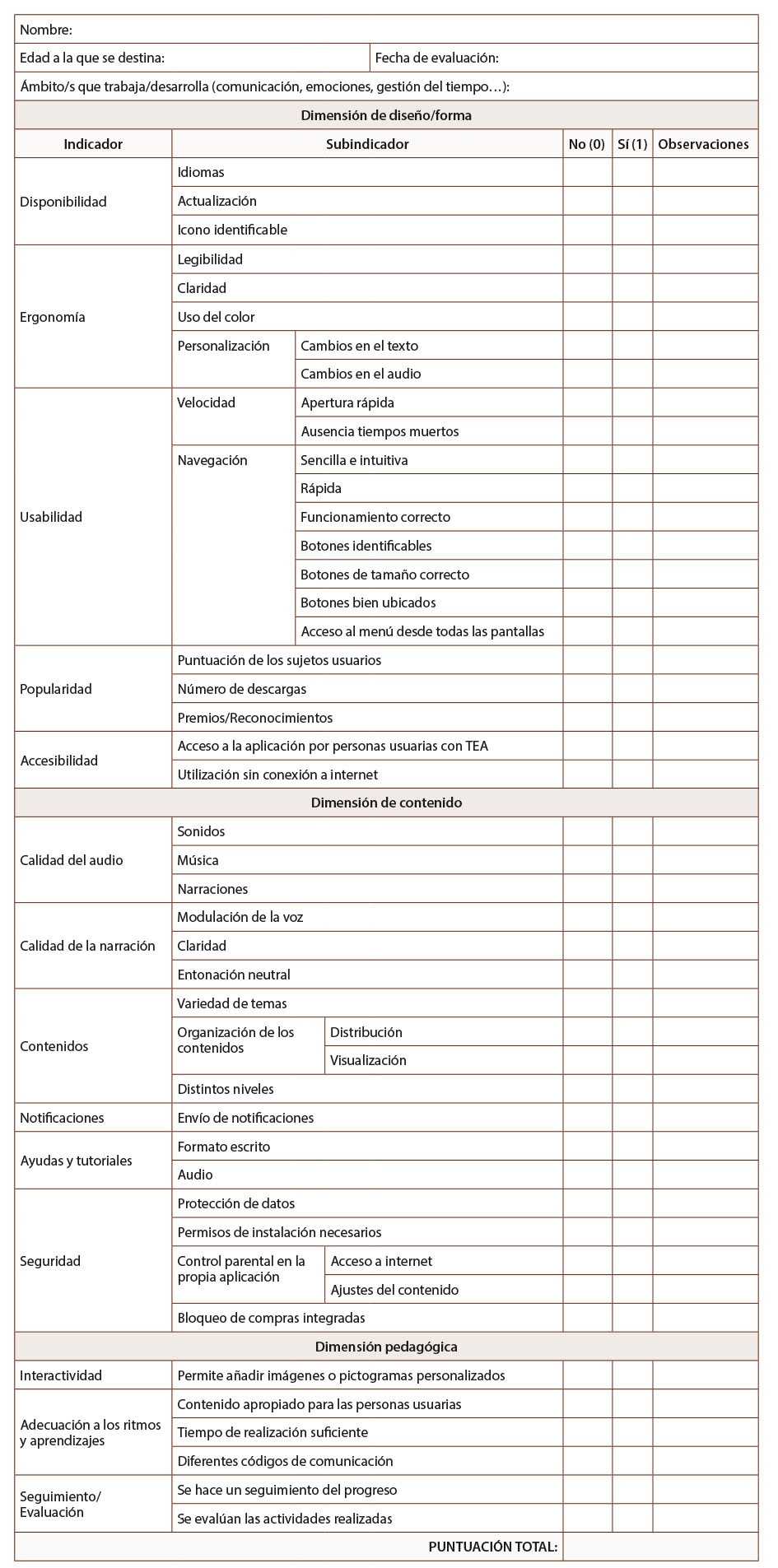

El sistema de indicadores desarrollado plantea tres dimensiones para valorar: diseño/forma, contenido y pedagogía. Inicialmente se consideró incluir los indicadores “precio de la app” y “sistema operativo”, pero ambos fueron excluidos ya que la idea es la de ofrecer esta herramienta como medio útil para analizar aplicaciones y, cabe destacar que, en los centros educativos se conceden Tablets con sistema operativo Android con aplicaciones gratuitas, por lo que estos elementos no serían relevantes en este análisis.

A continuación, se presenta cada una de las dimensiones con sus indicadores correspondientes para evaluar aplicaciones en dispositivo móvil o Tablet. El valor concedido a cada indicador, en caso de que la aplicación presente dicho criterio, será de 1. También se incluye un apartado de “observaciones”, para cuando sea preciso completar cualitativamente una valoración.

A. Dimensión de diseño/forma (D1): cuando se pretende evaluar una aplicación suele atenderse primero a la presentación de sus aspectos formales, a cómo ha sido diseñada y conforme con qué criterios se ha desarrollado. Los indicadores planteados son:

A.1 Disponibilidad: “utilizamos el término disponibilidad para determinar la facilidad de acceso a la propia aplicación” (García-Rodríguez y Gómez-Díaz, 2015, p. 3).

A.1.1 Idiomas: se valorará que la aplicación presente varios idiomas. En caso afirmativo, se indicarán cuáles.

A.1.2 Actualización: este subindicador se relaciona con lo actualizada que se encuentra la aplicación. Se ha considerado que una aplicación está actualizada cuando la última actualización no supere los tres años.

A.1.3 Icono identificable: resulta relevante que una aplicación cuente con un icono que la identifique con el contenido y sea reconocible por el usuario.

A.2 Ergonomía: se refiere a los aspectos vinculados a la visualización de la aplicación, en relación con el color, el tipo y el tamaño de la letra y la claridad del contenido.

A.2.1 Legibilidad: se relaciona con la legibilidad de los textos en las diferentes pantallas de la aplicación. Básicamente, si el tipo de letra y el tamaño facilitan la lectura.

A.2.2 Claridad: la claridad de la pantalla es esencial para visualizar correctamente el contenido. El fondo y las letras deben contener colores que faciliten la lectura.

A.2.3 Uso del color: los colores deben estar en armonía con la plataforma, con tonos uniformes que atraigan la atención del sujeto usuario, pero sin distraerlo de la tarea. La tonalidad adecuada dependerá de la sensibilidad de la persona usuaria, pero, por lo general, especialistas se decantan por colores fuertes.

A.2.4 Personalización: las aplicaciones pueden presentar la opción de cambiar su aspecto y adaptarlo a las necesidades del usuario. Se evaluará, si permite modificaciones en los aspectos formales del texto (color, tamaño y tipo de letra) o del audio (eliminación de la música o el idioma del narrador).

A.3 Usabilidad: según la Organización Internacional para la Estandarización (ISO 250000, 2018) la usabilidad se refiere a la capacidad del producto software para ser entendido, aprendido, usado y resultar atractivo para el usuario, cuando se usa en determinadas condiciones (ISO/IEC 25010). La usabilidad depende no solo del producto sino también del sujeto usuario, y según Nielsen (2000) el diseño debe esforzarse por mostrar las actividades de la forma más clara posible y sin actividades que den lugar a confusión.

A.3.1 Velocidad: se relaciona con el tiempo que emplea la aplicación en abrirse. Lo ideal es una apertura instantánea, o como máximo de unos 5 segundos.

A.3.2 Navegación: la navegación tiene que ser tarea fácil, apreciándose iconos que hagan de la aplicación, un espacio donde se produzca aprendizaje de manera clara, rápida e intuitiva, sin pausas innecesarias ni errores.

A.4 Popularidad: García-Rodríguez y Gómez-Díaz (2015) hacen alusión a la popularidad que otorga a la aplicación el número de descargas que esta tenga. De esta forma consideran:

A.4.1 Puntuación del público usuario: hace referencia a las valoraciones que hacen los usuarios en las webs de descarga. Usualmente, se valora con una escala de 1 a 5. Se valorará de manera positiva que la puntuación en Google Play Store sea ≥4.

A.4.2 Número de descargas: uno de los mejores indicadores de la popularidad y, por tanto, también de la calidad es el número de descargas. El dato de descargas está presente en Google Play Store según los siguientes criterios: Gris de 1 a 5.000 descargas; Azul de 10.000 a 50.000; Verde de 100.000 a 500.000; y Naranja 1.000.000 o más. Se valorará positivamente que tenga más de 50.000 descargas.

A.4.3 Premios o reconocimientos recibidos: se valorará que la aplicación posea algún premio o reconocimiento y se describirá cuál es en el apartado de “observaciones”.

A.5 Accesibilidad: según Gil González (2013, p. 9) “una aplicación es accesible cuando cualquier usuario, independientemente de su diversidad funcional, puede utilizarla en su dispositivo móvil satisfactoriamente con su sistema de acceso habitual”. Las personas con diversidad funcional presentan un amplio abanico de necesidades, derivadas del nivel de afectación que presenten, así, una aplicación será accesible, si cubre “todas las necesidades que un usuario pueda requerir” (Aguado Delgado y Estrada Martínez, 2017, p. 11).

A.5.1 Acceso a la aplicación por público usuario con TEA: este subindicador indica si la aplicación atiende a las características del público usuario con TEA y le posibilita su acceso.

A.5.2 Utilización sin conexión a internet: uso de la aplicación sin conexión a internet.

B. Dimensión de contenido (D2): se pretenden valorar varios aspectos:

B.1 Calidad del audio: el audio debe ser apropiado para la población destinataria (Araujo et al., 2007); hace referencia a la música, voz y sonidos.

B.1.1 Sonidos: se evaluarán positivamente las aplicaciones con sonidos de buena calidad.

B.1.2 Música: las aplicaciones que incluyan música serán valoradas positivamente.

B.1.3 Narración: la voz que relate cómo proceder en cada actividad debe tener una entonación adecuada durante todo el trascurso del audio.

B.2 Calidad de la narración: la narración debe ser adecuada y entendida sin dificultad.

B.2.1 Modulación de la voz: los cambios en el tono, volumen, ritmo, pronunciación y velocidad deben ser acordes a las actividades planteadas.

B.2.2 Claridad: la voz debe de ser comprensible y perceptible por el usuario.

B.2.3 Entonación neutral: la voz narradora debe de expresar adecuadamente los tonos exclamativos, interrogativos o enunciativos.

B.3 Contenidos: este indicador se destina a la comprobación de que el contenido se adapte a las necesidades de las personas con TEA.

B.3.1 Variedad de temas: la variedad en los temas, tareas, actividades y juegos disponibles supone un aspecto deseable en una aplicación.

B.3.2 Organización de los contenidos: la distribución de los contenidos es fundamental para que el usuario pueda acceder de forma adecuada.

B.3.3 Diferentes niveles: es deseable que las aplicaciones incluyan distintos niveles de ejecución en función de dificultad o la edad de la persona con TEA.

B.4 Notificaciones: la aplicación puede enviar notificaciones, aunque no se esté utilizando es ese momento, las cuales aparecerán en la barra de notificaciones del dispositivo móvil o por vía e-mail. Se valorará positivamente que la aplicación las incluya.

B.5 Ayudas y tutoriales: los apartados de ayuda (como texto escrito o en audio) son útiles para entender las actividades, por lo que es conveniente que la aplicación los incluya.

B.6 Seguridad: desde el año 2001 existe un código europeo de autorregulación para productos de software interactivo (videojuegos, juegos de ordenador, artículos de educación, …) que tiene como objetivo “informar de forma objetiva y responsable a padres, educadores y al público en general, sobre el contenido … y … la edad para la que se consideran adecuados” (Pérez Alonso-Geta, 2008, p. 37). El sistema PEGI (Pan European Game Information System) “es el mecanismo de autorregulación diseñado por la industria para dotar a sus productos de información orientativa sobre la edad adecuada para su consumo” (Asociación Española de Videojuegos, 2015, párr. 1). De esta manera, se facilita la elección de productos ajustados a la etapa evolutiva del público usuario, restringiendo la interacción de infantes con contenidos inadecuados. Las aplicaciones para personas menores con TEA cuentan con este sistema para clasificar el contenido. Así, en el indicador seguridad se incluye:

B.6.1 Protección de datos: todas las aplicaciones, y mucho más las destinadas a personas menores, deben garantizar la protección de “datos de manera que personas o sistemas no autorizados no puedan leerlos o modificarlos” (Costilla Quiroz y de la Cruz Berrospi, 2016, p. 30). Se valorará si la aplicación cuenta con mecanismos que garanticen la confidencialidad y la privacidad.

B.6.2 Permisos que solicita al instalar la aplicación: las aplicaciones solicitan “acceso a las funciones de teléfonos inteligentes y tabletas, tales como ubicación y libreta de contactos” (We live security, 2015, párr. 1), aspectos que no deberían ser concedidos y que pueden considerarse innecesarios. Este subindicador vislumbra si la aplicación solicita permisos excesivos en relación con su uso.

B.6.3 Control parental en la propia aplicación: es recomendable la existencia de un sistema de control parental en la propia aplicación, se valorará su presencia respecto al acceso a internet o a los ajustes.

B.6.4 Bloqueo de compras integradas: existen aplicaciones que incluyen compras para avanzar de nivel o para acceder a material complementario. Se valora positivamente que presente algún tipo de bloqueo de compras en la propia aplicación.

C. Dimensión pedagógica (D3): este apartado se centra en las posibilidades que ofrecen las actividades propuestas en la aplicación para personas usuarias con TEA:

C.1 Interactividad: la interactividad según García-Rodríguez y Gómez-Díaz (2015) “permite al lector actuar y participar como un personaje más de la historia y tomar decisiones en el proceso de lectura. Por ello es conveniente comprobar si la aplicación … incluye animación e interactividad, si está equilibrada, si es excesiva” (p. 11).

C.1.1 Permite añadir imágenes o pictogramas personalizados: se valorará positivamente que la aplicación incluya la opción de añadir pictogramas propios o imágenes que representen rutinas en casa o colegio para favorecer el aprendizaje significativo.

C.2 Adecuación a los ritmos y aprendizajes: Belloch Ortí (2006) plantea la importancia de adaptar las aplicaciones a las características del sujeto usuario, proponiendo ritmos de aprendizaje flexibles, y adaptando la interface al uso de diferentes códigos de comunicación (visual o auditivo). Para poder medir este apartado se valorará:

C.2.1 Contenido apropiado para los sujetos usuarios: el contenido tiene que ser apropiado para la edad y relacionado con la finalidad de la aplicación.

C.2.2 Tiempo de realización suficiente: es importante que se respeten los tiempos en los que el sujeto usuario está resolviendo un juego de asociación o interpretando una locución o cuento. La aplicación no debería de establecer un tiempo de resolución.

C.2.3 Diferentes códigos de comunicación: resulta atractivo para la persona con TEA que las situaciones mostradas propongan diferentes códigos, como el auditivo o el visual, para poder interpretar mejor lo que la aplicación pretende enseñar.

C.3 Seguimiento/evaluación: Belloch Ortí (2006) resalta la utilidad de que la aplicación ofrezca un seguimiento y evaluación de las actividades realizadas. De esta forma:

C.3.1 Se hace un seguimiento del progreso: se valorará si posee un sistema de seguimiento que permita una evaluación formativa del aprendizaje realizado.

C.3.2 Se evalúan las actividades realizadas: se valorar si posee un sistema de evaluación de las actividades.

Para finalizar, se precisa una interpretación de lo obtenido; en este sentido, hay que establecer qué puntuación será la óptima, de forma que se especifique cuáles serían las aplicaciones adecuadas. El instrumento consta de un total de 14 indicadores, subdivididos en 46 subindicadores, de tal manera que la puntuación de la dimensión diseño/forma oscilará entre 0 y 22 puntos; la de contenido entre 0 y 18 puntos; la pedagógica entre 0 y 6 puntos; y la total entre 0 y 46 puntos. Así, tomando como referencia los tres niveles de aplicaciones establecidos por García-Rodríguez y Gómez-Díaz (2015) y dado que la puntuación total máxima será 46 puntos, la interpretación y valoración de las aplicaciones seguirán los siguientes parámetros:

1. Altamente recomendables: puntuación ≥ 37 (entre 80% y 100% de indicadores).

2. Recomendables: puntuación entre 23 y 36 (entre el 50% y 79% de indicadores).

3. Prescindibles: puntuación ≤ 22 (menos del 49% de los indicadores).

Una vez concluida la explicación de cada uno de los indicadores desarrollados, es preciso mostrar la hoja de registro que hará operativa la evaluación (Ver Figura 1).

Figura 1: Sistema de indicadores de evaluación de aplicaciones destinadas a personas usuarias con TEA

Nota: Elaboración propia.

Aplicación del método del juicio experto para la validación del sistema de indicadores

Se realizó un estudio instrumental de validez de contenido. Esta metodología de investigación consiste en el desarrollo de pruebas y aparatos, incluyendo tanto el diseño o adaptación como el análisis de las propiedades psicométricas de estos mismos (Montero y León, 2007).

Para la validación del sistema de indicadores, se utilizó el método basado en juicio expertos y jueces, ya que como señalan Escobar-Pérez y Cuervo-Martínez (2008) es un método de validación útil para verificar la confiabilidad de un instrumento de evaluación y, como estrategia de evaluación, presenta una serie de ventajas (Cabero Almenara y Llorente Cejudo, 2013) entre las que se encuentra “la posibilidad de obtener información pormenorizada sobre el tema sometido a estudio” (p. 14) y la calidad de las respuestas de los jueces y personas expertas.

Este puede hacerse de manera individual, grupal o a través del método Delphi. El método utilizado fue el método individual, en el que la información pertenece a una persona experta en su campo. A cada individuo, se le pide dar una estimación directa de los elementos del instrumento. Esto permite al equipo experto expresar su juicio de manera objetiva, sin intercambiar opiniones y puntos de vista (Cabero Almenara y Llorente Cejudo, 2013), no suponiendo esto una limitación, ya que evita los sesgos ocasionados por conflictos interpersonales o presiones entre las personas expertas (Corral, 2009).

Para la realización del juicio experto se prepararon las instrucciones y módulos; se seleccionaron los sujetos expertos y se les instruyó posibilitando la discusión de los indicadores a través de la explicación detallada del contexto, así como brindándoles toda la información relevante sobre el uso que tendría el sistema de indicadores. Finalmente, el acuerdo entre el grupo se midió calculando la consistencia de sus respuestas (Skjong y Wentworht, 2001 citados en Escobar-Pérez y Cuervo-Martínez, 2008).

Sobre la determinación del número de sujetos expertos necesarios para la validez no hay un acuerdo unánime; Escobar-Pérez y Cuervo-Martínez (2008) afirman que “el número … que se debe emplear en un juicio depende del nivel de experiencia y de la diversidad del conocimiento” (p. 29). Así, se seleccionaron 12 personas expertas mediante un muestreo no probabilístico por conveniencia, según los criterios de selección de Skjong y Wentworht (2001), que son experiencia en la realización de juicios y toma de decisiones basada en evidencia o experticia (grados, investigaciones, publicaciones, posición, experiencia y premios entre otros), reputación en la comunidad, disponibilidad y motivación para participar, imparcialidad y cualidades inherentes como confianza en sí y adaptabilidad.

Del total de las personas expertas, cuatro eran docentes de la Facultad de Ciencias de la Educación de la Universidad de Granada (tres hombres y una mujer). Se les contactó vía correo electrónico institucional, donde se les adjuntó una carta formal de invitación para participar en la investigación, que fue descrita perfiladamente. Se les ofreció, junto al plazo de entrega, los datos institucionales de todos los sujetos implicados en la investigación, para entrar en contacto, en caso necesario. El criterio seguido para su inclusión fue su amplia formación académica y científica en las áreas de conocimiento de atención a la diversidad en educación primaria, atención a la diversidad en el aula de infantil, educación inclusiva, didáctica y pedagogía especial, atención psicoeducativa a personas con necesidades educativas especiales y atención educativa a las necesidades especiales. Su edad variaba entre los 36 y los 45 años (M= 39,75 (DT= 3,77), la totalidad con doctorado y con un rango de experiencia profesional entre los 10 y los 19 años (M= 15,2, DT= 4,11).

Dado que el sistema de indicadores quiere facilitar la selección de aplicaciones por parte de docentes y familiares, estos grupos también fueron sometidos a la opinión y juicios de especialistas que trabajaban con personas con TEA. Así, participaron un grupo de cuatro especialistas (un hombre y tres mujeres), con un rango de edad de 39 a 44 años (M= 41,75; DT= 2,50), con una experiencia entre los 4,5 años y los 23 (M= 13,12; DT= 7,85), y cuya formación inicial era diplomado en Maestro Especialidad Educación Especial (75%) y Psicología (25%). Estos sujetos expertos suponían una representación variopinta muy interesante de especialistas que pueden trabajar con las personas con TEA, pues se contó con una especialista que trabajaba con niños y niñas en un aula de autismo en un centro público de educación infantil y primaria, otro que trabajaba en un centro de educación especial, otro que lo hacía en un equipo de orientación educativa (con lo que tiene a su cargo varios centros educativos), y otro que dirigía una unidad de día con taller ocupacional para personas adultas con diversidad funcional.

Y, por último, también se ha contado con cuatro personas expertas (tres hombres y una mujer) en el campo de la informática, las TIC y las aplicaciones. Tenían una media de edad de 34 años (DT= 6,48), con un rango que va desde los 27 a los 42 años, el 75% tenía como formación un ciclo formativo de grado superior relacionado con los sistemas informáticos, el diseño gráfico o la automatización y el 25% cursó ingeniería industrial de electricidad, y contaban con una experiencia profesional media de 12 años (DT= 6,78) con un rango de 5 a 20 años en el sector privado.

Las personas expertas recibieron información previa sobre los objetivos del estudio. Tras la aceptación de la participación en el proceso de validación, se les envió vía email el sistema de indicadores acompañado de una carta de presentación con las instrucciones a seguir. El enfoque seguido en el juicio experto fue cuantitativo y cualitativo para la evaluación del sistema de indicadores. Para la evaluación cuantitativa, debían validar los indicadores y subindicadores en base a los criterios de: claridad (“Está formulado con lenguaje apropiado y comprensible. Se comprende fácilmente”), coherencia (“Es adecuado para el objetivo del estudio. Tiene relación lógica con la dimensión o indicador que está midiendo”), relevancia (“Grado de importancia para la dimensión. Es esencial o importante y, por tanto, debe ser incluido”) y objetividad (“Permite medir hechos observables”), con una escala de 1 a 4, donde: 1=deficiente, 2=aceptable, 3=bueno y 4=excelente. Para la evaluación cualitativa, podían efectuar sugerencias de mejora y comentarios en extenso, así como proponer la eliminación de indicadores o subindicadores.

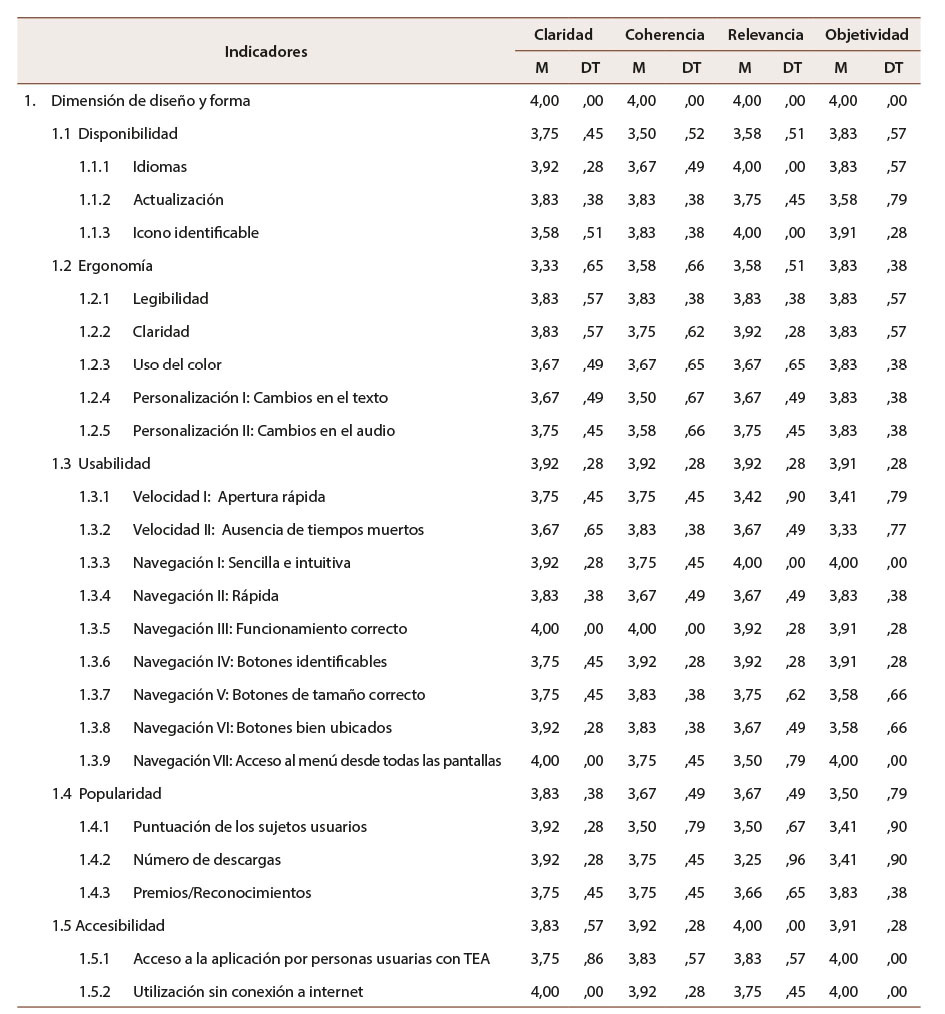

Para cada uno de los indicadores y subindicadores, se calculó la media y desviación típica como medida central de la tendencia de respuesta del grupo experto. Para la primera dimensión, sobre el diseño y la forma de la aplicación (Tabla 1) se identifican en su totalidad altas puntuaciones. Como puede observarse, la media más alta (M= 4.00) para el criterio de claridad se obtuvo en la propia dimensión y en los subindicadores Navegación III: Funcionamiento correcto, Navegación VII: Acceso al menú desde todas las pantallas y Utilización sin conexión a internet y la más baja para el subindicador Icono identificable (M= 3,58). Estos resultados mostraban que los indicadores y subindicadores de la primera dimensión se comprendían con facilidad y estaban formulados con lenguaje apropiado y comprensible. Respecto a la coherencia, de nuevo la media más alta (M = 4,00) se obtuvo para la propia dimensión y para el subindicador Navegación III: Funcionamiento correcto, y la más baja para el subindicador Personalización I: Cambios en el texto (M = 3,50). De nuevo, estos valores resultaron satisfactorios pues revelaban que los indicadores y subindicadores diseñados para la primera dimensión eran adecuados para el objeto de estudio y tenían una relación lógica con la dimensión que estaban midiendo. Atendiendo a la relevancia, se encontró que la dimensión en sí era considerada esencial por el equipo experto (M= 4,00), así como el indicador de la accesibilidad y los subindicadores de los idiomas, el icono identificable y la navegación I: sencilla e intuitiva (M= 4,00). En cambio, el subindicador número de descargas (M= 3,22) fue considerado como el menos importante. Estos resultados señalaban que los indicadores y subindicadores seleccionados para esta primera dimensión fueron los adecuados. Y, por último, respecto a la objetividad, encontramos que el grupo de jueces consideró que se trataba de una dimensión objetiva (M= 4,00), y, además, los subindicadores que puntúan más alto a la hora de medir hechos observables fueron el acceso a la app por usuarios con TEA, la utilización sin conexión a internet, la navegación I: sencilla e intuitiva y la navegación VII: acceso al menú desde todas las pantallas; siendo el subindicador que puntuó más bajo el velocidad II: ausencia de tiempos muertos (M = 4,33). En este sentido, el subindicador velocidad I: apertura rápida obtiene una media de 4,41; pues el grupo experto del ámbito informático resaltó que tenía que ver con el terminal utilizado para abrir la aplicación, por lo que recomendaba indicar el tipo de equipo con el que se ha realizado el análisis de la aplicación.

Tabla 1: Media y desviación típica de las valoraciones dadas por los grupos expertos para la dimensión de diseño y forma de la aplicación

Nota: Elaboración propia.

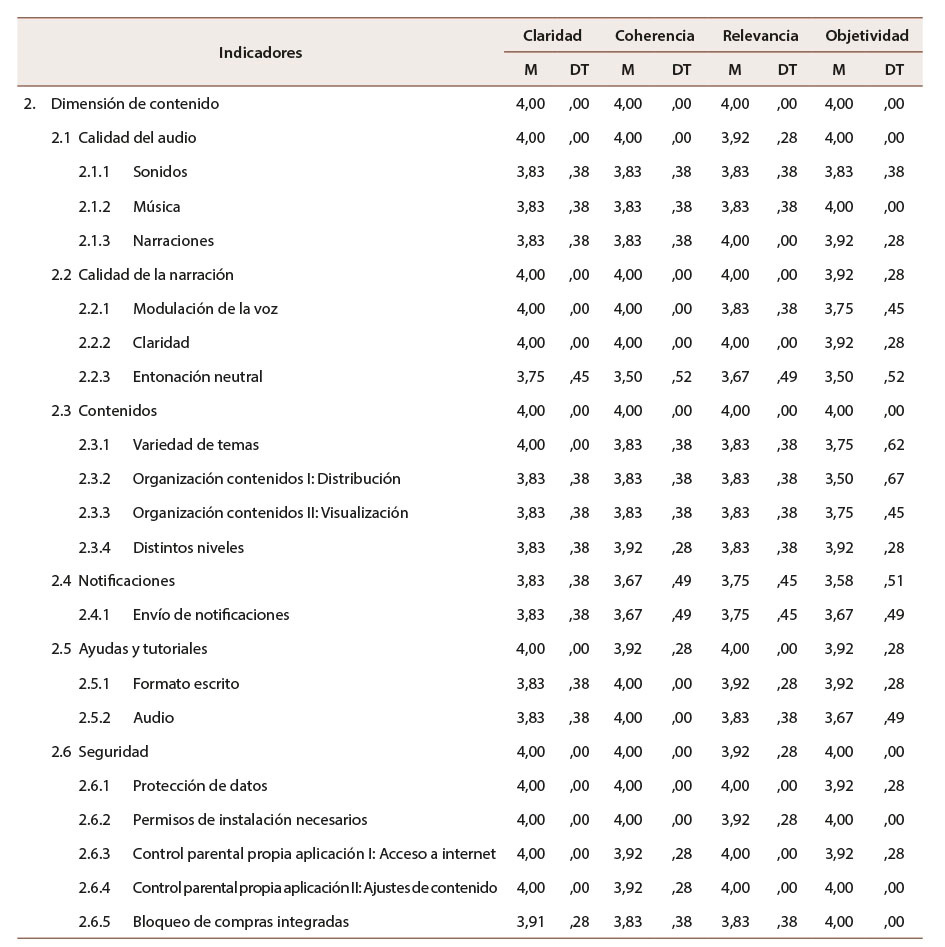

En cuanto a la dimensión de contenido, el grupo experto otorgó altas puntuaciones (entre bueno y excelente) a todos los indicadores y subindicadores seleccionados (Tabla 2). El 52% obtuvo una media de 4, lo que indicaba una claridad excelente; el subindicador entonación neutral fue el que puntuó más bajo, con una media de 3,75. El 44% de los indicadores y subindicadores presentó una coherencia excelente, con una media de 4; volviendo a ser de nuevo el subindicador entonación neutral el que puntuó más bajo (M = 3,50). El 36% de los indicadores y subindicadores alcanzó los 4 puntos respecto a su relevancia, el 56% entre 3,92 y 3,75 puntos, el subindicador considerado como menos relevante fue la entonación neutral (M = 3,67). El 32% de los indicadores y subindicadores presentaban, según jueces, una objetividad excelente, el 52% entre 3,92 y 3,75; donde los subindicadores que puntuaron más bajo fueron la entonación neutral y organización contenidos I: distribución. De las valoraciones puede desprenderse que el ítem en conjunto peor valorado de la segunda dimensión es la entonación neutral, no obstante, sus puntuaciones son elevadas, por lo que no se consideró necesario eliminarlo ni reformularlo.

Tabla 2: Media y desviación típica de las valoraciones dadas por los grupos expertos para la dimensión de contenido de la aplicación

Nota: Elaboración propia.

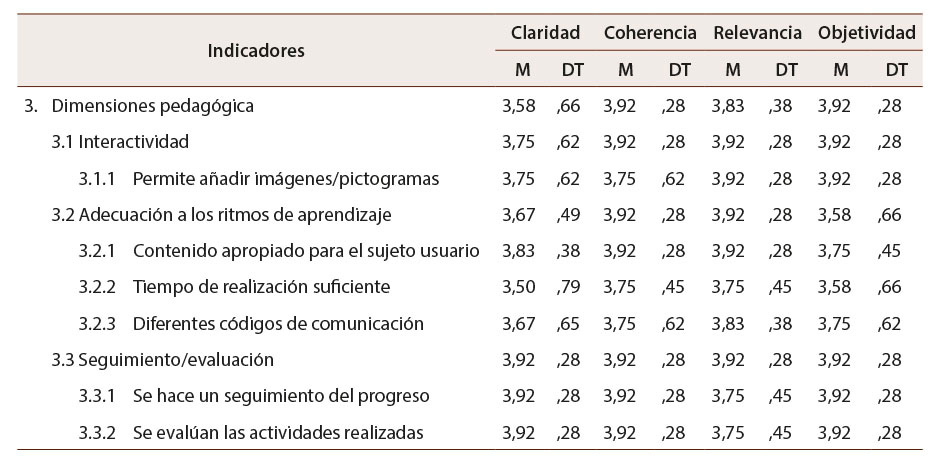

La dimensión pedagógica también logró buena puntuación, aunque ninguno de sus indicadores y subindicadores alcanzó los 4 puntos de forma unánime (Tabla 3). Así, atendiendo al criterio de claridad, los mejores indicadores fueron los relacionados con el seguimiento y evaluación (M = 3,92) y los menos claros el tiempo de realización suficiente. El 70% presentó un alto grado de coherencia con una media de 3,92, y el restante 30% puntuó 3,75, por lo que puede afirmarse que todos los indicadores y subindicadores de esta dimensión eran adecuados para el objetivo del estudio. En cuanto a la relevancia, el 50% puntuó 3,92 y el resto entre 3,75-3,83; por lo que eran importantes para el estudio y debían ser incluidos. Y, finalmente, respecto de la objetividad, el 60% obtuvo 3,92 puntos; el indicador adecuación a los ritmos de aprendizaje y el subindicador tiempo de realización suficiente son los que puntuaron más bajo (M = 3,58).

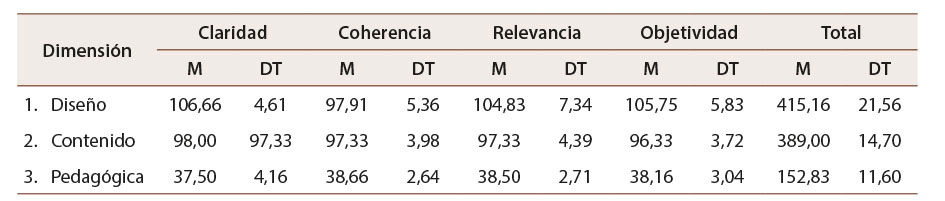

Tomando en consideración cada dimensión en su conjunto, respecto a los diferentes criterios, cabe inferir lo siguiente (Tabla 4): La primera dimensión de diseño y forma de la aplicación obtuvo puntuaciones globales altas, ya que la máxima puntuación que podían otorgarle era de 112 en cada criterio, y es en la claridad en la que obtiene la mayor puntuación (M = 106,66), la menor en la coherencia (M = 97,91) y una puntuación total de 415,16 puntos sobre 448 posibles. Estos resultados indican que se trata de una dimensión que debe estar presente a la hora de evaluar las aplicaciones para personas con TEA. La segunda dimensión de contenido también alcanzó puntuaciones elevadas, pues la máxima puntuación que podía obtener era 100 puntos, obteniendo la puntación más alta en claridad (M = 98,00), la más baja en objetividad (M = 96,33) y una puntuación total de 389,00 de un máximo de 400. De nuevo, puede afirmarse que se trataba de una dimensión necesaria para la evaluación de aplicación. Y la tercera dimensión, la pedagógica, fue valorada con una alta puntuación, otorgándole totales muy próximos en los criterios de coherencia, relevancia y objetividad, en torno a 38 puntos de 40 posibles, donde el de claridad es el que obtiene una puntuación ligeramente inferior (M = 37,50), y una puntuación total de 152,83 puntos de 160 posibles.

Tabla 3: Media y desviación típica de las valoraciones dadas por los grupos expertos para la dimensión pedagógica de la aplicación

Nota: Elaboración propia.

Tabla 4: Media y desviación típica de las valoraciones dadas por los grupos expertos para la cada dimensión en su conjunto

Nota: Elaboración propia.

Una vez analizadas las valoraciones realizadas, para determinar el grado de acuerdo entre se calcularon los coeficientes de correlación intraclases (ICC) y de concordancia externa W de Kendall. Dichos coeficientes son utilizados para valorar y evaluar la confiabilidad ínter-observador (Bao et al., 2009). “Su cálculo se basa en [dividir] en dos partes la variabilidad total de las evaluaciones realizadas; por una parte, la variación debida a la diferencia entre los elementos a evaluar” (Rodríguez Ruiz y Heredia Rico, 2013, p. 48); y por otra, la variabilidad atribuible a la diferencia entre las valoraciones del grupo experto (Shrout y Fleiss, 1979). El ICC está comprendido entre 0 y 1; cuanto mayor valor tenga este coeficiente menor variabilidad es atribuible a la diferencia entre las valoraciones, es decir, mayor acuerdo existe entre las personas expertas. Los resultados obtenidos con respecto al coeficiente de correlación intraclase son: ,955 (D1), ,973 (D2) y ,966 (D3); como estos valores son superiores a ,750 (Shrout y Fleiss, 1979) indicaban que la confiabilidad inter-jueces fue excelente.

El coeficiente de Kendall:

indica el grado de asociación o nivel de concordancia, como medida de acuerdo entre los rangos de las evaluaciones realizadas por jueces … [a un instrumento determinado], con un rango de 0 a 1, … [donde] el valor 1 representa un nivel de concordancia total, y 0 un desacuerdo total. (Dorantes-Nova et al., 2016, p. 332)

Cuanto mayor es el valor Kendall más intensa es la asociación que otorga validez y confiabilidad al instrumento. Para que el instrumento pueda ser utilizado para los fines para los cuales fue diseñado y si se han obtenido bajos niveles de concordancia, el ítem en cuestión puede modificarse o suprimirse para alcanzar el objetivo de medición pretendido (Escobar-Pérez y Cuervo-Martínez, 2008). Los niveles de acuerdo medidos con W son interpretados de la siguiente forma (Siegel y Castellan, 1988): ,000 < W < ,600 acuerdo pobre; ,600 ≤ W < ,700 acuerdo moderado; ,700 ≤ W < ,800 buen acuerdo y, ,800 ≤ W ≤ 1,00 acuerdo fuerte. Así, para el criterio de calidad, el coeficiente de Kendall fue estadísticamente significativo y con un grado de acuerdo fuerte (W= ,980, p= ,000); para el de coherencia fue estadísticamente significativo y con un buen grado de acuerdo (W= ,757, p= ,000); para el de relevancia fue estadísticamente significativo y el grado de acuerdo resultó fuerte (W= ,861, p= ,000), y para el de objetividad fue estadísticamente significativo con un grado de concordancia interjueces total (W= 1,00, p= ,000). Los resultados denotan que con un nivel de significación del 5% existía evidencia de la concordancia entre sujetos expertos en cuanto a la claridad, coherencia, relevancia y objetividad de la propuesta; esto es que el sistema de indicadores y el instrumento de evaluación resultaron válidos.

Finalmente, se realizó el análisis de fiabilidad empleando el coeficiente alfa de Cronbach. En todas las dimensiones analizadas los valores del coeficiente α estuvieron por encima de ,900: ,955 (D1), ,973 (D2) y ,966 (D3), y, por lo tanto, fueron excelentes (Hernández Sampieri et al., 2006). Lo que demostró la consistencia interna del sistema de indicadores y el instrumento de evaluación diseñado.

Conclusiones

El uso de medios tecnológicos como puente para favorecer el aprendizaje en el ámbito educativo ha ido cobrando importancia con el paso de los años. Ello deja ver cómo la tecnología avanza y conecta con todo tipo de colectivos sociales, creando entornos que favorecen el aprendizaje de diferentes estudiantes, incluyendo aquellos grupos con necesidades educativas especiales. De este modo, diseñar entornos de aprendizaje accesible para toda la población es y será el objetivo principal de la sociedad del conocimiento.

Durante el diseño del sistema de indicadores, han ido floreciendo diferentes inquietudes acerca de la diversidad de aplicaciones existentes y los posibles criterios a valorar. Estos criterios han seguido un análisis en profundidad, de forma que se han seleccionado los que posibilitan una evaluación de las aplicaciones lo más enriquecedora posible. Se pretende, ante todo, que este instrumento sea intuitivo y completo, ya que se ha partido de estudios previos con gran rigor científico. Como se ha podido comprobar, es necesario contar con materiales y herramientas que faciliten al usuario la elección de las aplicaciones que mejor se adapten a las necesidades de la persona con TEA. En este sentido, la búsqueda por parte de especialistas y familiares partirá de parámetros previamente establecidos y con criterios adecuados al ámbito que se quiera trabajar con la persona con TEA.

Existe un amplio abanico de aplicaciones destinadas a personas usuarias con TEA, y realizar una exploración acerca de lo que cada una de ellas ofrece no es sencillo. Sin embargo, resulta imprescindible indagar en las funcionalidades que presentan cada una de ellas, ya que, al hablar de una necesidad especial, el proceso de aprendizaje es particular. De esta forma, ser meticuloso en este aspecto y reflexionar sobre los materiales y herramientas ofrecidas a estas personas es relevante para ofrecerles la calidad de vida merecida. Dado que las TIC han avanzado y a día de hoy resultan enriquecedoras para personas con TEA, hacer un uso adecuado de ellas supone un auge en su aprendizaje.

El sistema de indicadores y el instrumento diseñado para la evaluación de aplicaciones para personas con TEA, sometido al juicio experto han resultado válidos y fiables. Las dimensiones, los indicadores y subindicadores recibieron puntuaciones altas (entre buenas y excelentes). El coeficiente de confiabilidad inter-jueces (ICC) fue excelente. Y el coeficiente W de Kendall mostró una concordancia significativa entre jueces en cuanto a la claridad, coherencia, relevancia y objetividad de la propuesta y un alto índice de concordancia entre los rangos asignados. Por tanto, el sistema anterior se torna sólido, con indicadores que tienen alto nivel de logro y con unos niveles de consistencia interna excelentes.

En futuros estudios se analizarán las aplicaciones disponibles para Android con el instrumento diseñado, con motivo de su validación experimental. Tras el proceso de validación experimental, y como continuación de ella, se presentará un ranking de las mejores aplicaciones por ámbitos de desarrollo para alumnado con TEA, que sea de utilidad para docentes y progenitores. Para cerrar este apartado de prospectiva y proyección del presente trabajo, cabe indicar que convendría adaptar los criterios de valoración de las aplicaciones para otros colectivos que, debido a sus especificidades, requieren características acordes a sus posibilidades, como personas con TDAH o con discapacidades sensoriales, motoras o intelectuales, entre otros.

Declaración de Material complementario

Este artículo tiene disponible, como material complementario:

-La versión preprint del artículo en https://doi.org/10.5281/zenodo.4042051

Referencias

Aguado Delgado, J. y Estrada Martínez, F. J. (2017). Guía de accesibilidad de aplicaciones móviles (APPS). Ministerio de Hacienda y Función Pública. https://sid.usal.es/versionimprimir.aspx?id=27483&fichero=8.4.1

Araujo, D., Bermúdez, J. y Núñez, Escobar S. D. (2007). Criterios de evaluación en aplicaciones multimedia en entornos de educación y formación a distancia. Revista Electrónica de Estudios Telemáticos, 6(2), 1-17. https://dialnet.unirioja.es/servlet/articulo?codigo=2961770

Asociación Española de Videojuegos. (2015). ¿Qué es el sistema PEGI? http://www.aevi.org.es/documentacion/el-codigo-pegi/

Bao, S., Howard, N., Spielholz, P., Silverstein, B., Polissar, N. (2009) Inter-rater reliability of posture observations Human Factors. The Journal of the Human Factors and Ergonomics Society, 51(3), 292-309. https://doi.org/10.1177/0018720809340273

Bellini, S. y Akullian, J. (2007). A meta-analysis of video modeling and video self-modeling interventions for children and adolescents with autism spectrum disorders. Exceptional Children, 73(3), 264-287. https://doi.org/10.1177/001440290707300301

Belloch Ortí, C. (2006). Evaluación de las aplicaciones multimedia: Criterios de calidad. Unidad de Tecnología Educativa, Universidad de Valencia. https://www.uv.es/bellochc/pdf/pwtic4.pdf

Cabero Almenara, J. y Llorente Cejudo, M. del C. (2013). La aplicación del juicio de experto como técnica de evaluación de las tecnologías de la información y comunicación (TIC). Eduweb. Revista de Tecnología de Información y Comunicación en Educación, 7(2), 11-22. http://servicio.bc.uc.edu.ve/educacion/eduweb/

Cafiero, J. M. (2005). Meaningful exchanges for people with autism: An introduction to augmentative & alternative communication. Woodbine House.

Campos Jiménez, K., Carvajal Jiménez, V., Castro Gutiérrez, E. R., Hutchinson Heath, S., Masís Muñoz, M., Murillo León, S., Rojas Alvarado, G., Rojas Ramírez, F. y Sánchez Chacón, G. (2014). Actividades de aprendizaje y TIC: Usos entre docentes de la Educación General Básica costarricense. Aproximación diagnóstica. Revista Electrónica Educare, 18(1), 239-263. https://doi.org/10.15359/ree.18-1.11

Corral, Y. (2009). Validez y confiabilidad de los instrumentos de investigación para la recolección de datos. Revista Ciencias de la Educación, 19(33), 228-247. https://www.semanticscholar.org/paper/Validez-y-confiabilidad-de-los-instrumentos-de-para-Franco-Josefina/229674820680f8acf233ad34bfefcc2306d56156

Costilla Quiroz, J. M. y de la Cruz Berrospi, E. J. (2016). Implementación de un software open source para la generación de valor del proceso de atención del área de helpdesk en la empresa Tal S. A. [Tesis de posgrado]. Universidad Privada Antenor Orrego. http://repositorio.upao.edu.pe/handle/20.500.12759/3411

Dorantes-Nova, J. A., Hernández-Mosqueda, J. S. y Tobón-Tobón, S. (2016). Juicio de expertos para la validación de un instrumento de medición del síndrome de Burnout en la docencia. RA Ximhai, 12(6), 327-346. https://doi.org/10.35197/rx.12.01.e3.2016.22.jd

Escobar-Pérez, J. y Cuervo-Martínez, Á. (2008). Validez de contenido y juicio de expertos: Una aproximación a su utilización. Avances en Medición, 6, 27-36. https://www.researchgate.net/publication/302438451_Validez_de_contenido_y_juicio_de_expertos_Una_aproximacion_a_su_utilizacion

Flores, M., Musgrove, K., Renner, S., Hinton, V., Strozier, S., Franklin, S. y Hil, D. (2012). A comparison of communication using the Apple iPad and a picture-based system. Augmentative and Alternative Communication, 28(2), 74-84. https://doi.org/10.3109/07434618.2011.644579

García-Rodríguez, A. y Gómez-Díaz, R. (2015). Las demasiadas aplicaciones: Parámetros e indicadores para seleccionar las topapp de lectura para niños. Anales de Documentación, 18(2), 1-17. https://doi.org/10.6018/analesdoc.18.2.227071

Gil González, S. (2013). Cómo hacer “Apps” accesibles. CEAPAT-IMSERSO. http://riberdis.cedd.net/handle/11181/4171

González Cintado, J. L., Montero Bueno, C., Batanero Rodríguez, M., Montero Bueno, E., de la Fuente Martínez, M. L. y González Muñoz, L. (2016). Una “inclusiva” mirada de la tecnología en nuestro colegio. Trabajando con una mirada especial: TEA y TIC en nuestro colegio. Padres y Maestros, (365), 41-48. https://doi.org/10.14422/pym.i365.y2016.006

Guzmán, G., Putrino, N., Martínez, F. y Quiroz, N. (2017). Nuevas tecnologías: Puentes de comunicación en el trastorno del espectro autista (TEA). Terapia Psicológica, 35(3), 247-258. http://dx.doi.org/10.4067/S0718-48082017000300247

Hernández Sampieri, R., Fernández Collado, C. y Baptista Lucio, P. (2006). Metodología de la investigación (4.º ed.). McGraw-Hill. https://www.academia.edu/31870211/Sampieri_et_al_metodologia_de_la_investigacion_4ta_edicion_sampieri

ISO 250000. (2018). Usabilidad. https://iso25000.com/index.php/normas-iso-25000/iso-25010/23-usabilidad

Jiménez Lozano, M. D., Serrano Sánchez, J. L. y Prendes Espinosa, M. P. (2017). Estudio de caso de la influencia del aprendizaje electrónico móvil en el desarrollo de la comunicación y el lenguaje con un niño con TEA. Educar, 53(2), 419-443. https://doi.org/10.5565/rev/educar.782

Larco, A., Almendáriz, V. y Luján-Mora, S. (2015). Evaluación de aplicaciones educativas para discapacidad intelectual utilizando MARS. En J. L. Rogel Villacis (Comp.), Memorias científicas del V Congreso Internacional de Investigación y actualización en ingenierías (pp. 300-308), CIDE Editorial. https://docs.wixstatic.com/ugd/54b18d_8d3fcb91e8fa459fb08e329ab2f34883.pdf

Lozano Martínez, J., Ballesta Pagán, F. J., Alcaraz García, S. y Cerezo Máiquez, M. C. (2014). Las tecnologías de la información y la comunicación (TIC) en el proceso de enseñanza y aprendizaje del alumnado con trastorno del espectro autista (TEA). Revista Fuentes, (14), 193-208. https://revistascientificas.us.es/index.php/fuentes/article/view/2359/2178

Mirenda, P. (2001). Autism, augmentative communication, and assistive technology: What do we really know? Focus on Autism and Other Developmental Disabilities, 16(3), 141-151. https://doi.org/10.1177/108835760101600302

Mirenda, P., Wilk, D. y Carson, P. (2000). A retrospective analysis of technology use patterns of students with autism over a five-year period. Journal of Special Education Technology, 15(3), 5-16. https://doi.org/10.1177/016264340001500301

Montero, I. y León, O. G. (2007). A guide for naming research studies in psychology. International Journal of Clinical and Health Psychology, 7(3), 847-862. https://dialnet.unirioja.es/ejemplar/164015

Nielsen, J. (2000).Usabilidad. Diseño de sitios web. Prentice Hall.

Parsons, S., Leonard, A. y Mitchell, P. (2006). Virtual environments for social skills training: Comments from two adolescents with autistic spectrum disorder. Computers & Education, 47(2), 186-206. https://doi.org/10.1016/j.compedu.2004.10.003

Pérez Alonso-Geta, P. (2008). Protección de la infancia y nuevas tecnologías de la comunicación: El código PEGI de regulación de los videojuegos y juegos on-line. Education in the Knowledge Society (EKS), 9(3), 29-47. https://doi.org/10.14201/eks.16739

Rodríguez Fuentes, A. (2017). Editorial. Caminando con sentido hacia la inclusión educativa mundial, RETOS XXI, 1(1), 9-15. http://revistas.utp.ac.pa/index.php/retoxxi/article/view/1516

Rodríguez Ruiz, Y. y Heredia Rico, J. J. (2013). Confiabilidad ínter-observador del método de evaluación de riesgo individual. Hacia la Promoción de la Salud, 18(1), 41-56. http://www.scielo.org.co/pdf/hpsal/v18n1/v18n1a04.pdf

Shrout, P. E. y Fleiss, J. L. (1979). Intraclass correlations: Uses in assessing rater reliability. Psychological Bulletin, 86(2), 420-428. https://doi.org/10.1037/0033-2909.86.2.420

Siegel, S. y Castellan, N. J., Jr. (1988). Nonparametric statistics for the behavioral sciences. McGrawHill.

Skjong, R. y Wentworth, B. H. (17-22 de junio, 2001). Expert judgment and risk perception. Conferencia presentada en Eleventh International Offshore and Polar Engineering Conference, Stavanger, Noruega. http://citeseerx.ist.psu.edu/viewdoc/summary?doi=10.1.1.194.6113

Terrazas Acedo, M., Sánchez Herrera, S. y Becerra Trave, M. T. (2016). Las TIC como herramienta de apoyo para personas con Trastorno del Espectro Autista (TEA). Revista Nacional e Internacional de Educación Inclusiva, 9(2), 102-136. https://revistaeducacioninclusiva.es/index.php/REI/article/view/285/310

We live security (Ed.) (2015). ¿Con qué permisos de aplicaciones deberías tener cuidado? https://n9.cl/drrx

Artículo de la Revista Electrónica Educare de la Universidad Nacional, Costa Rica by Universidad Nacional is licensed under a Creative Commons Attribution-NonCommercial-NoDerivs 3.0 Costa Rica License.

Based on a work at https://www.revistas.una.ac.cr/index.php/EDUCARE

Permissions beyond the scope of this license may be available at educare@una.ac.cr